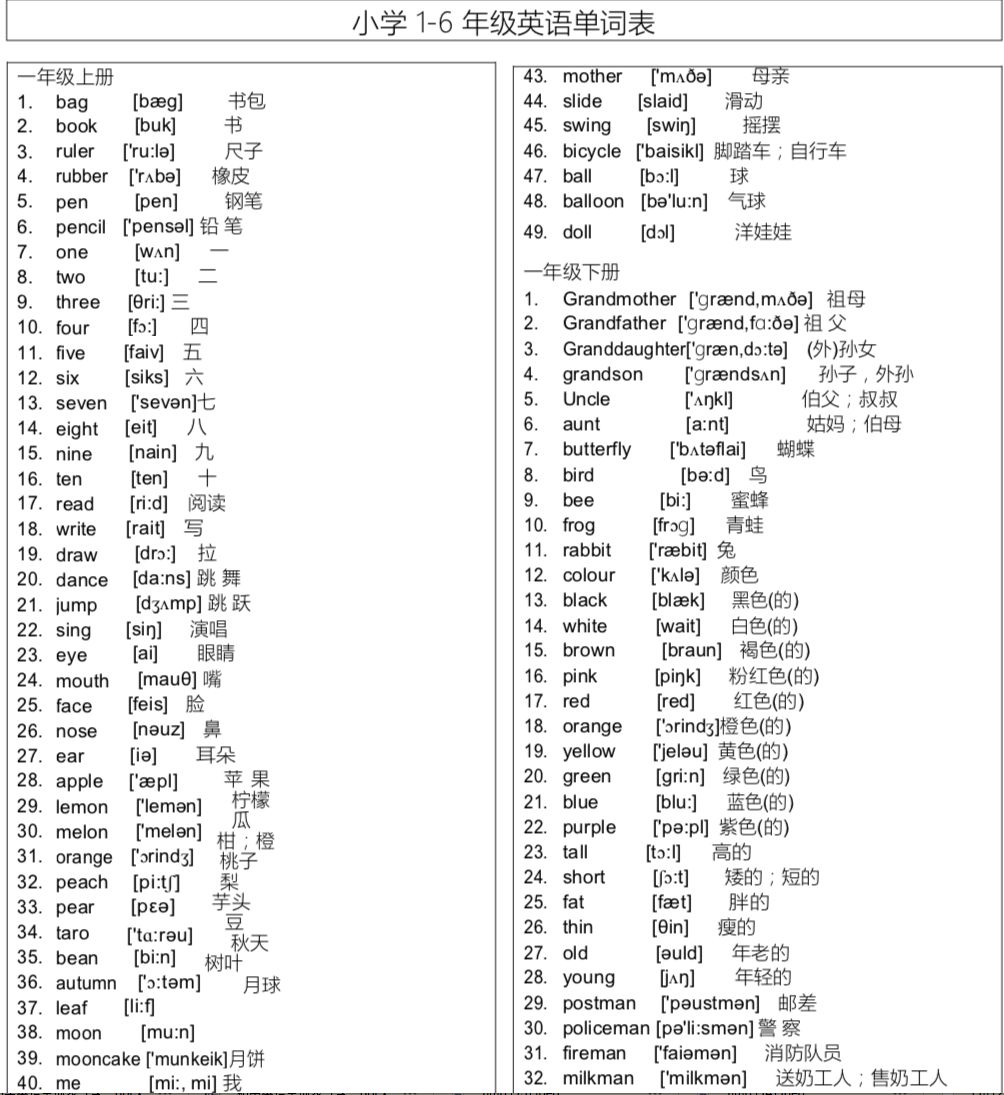

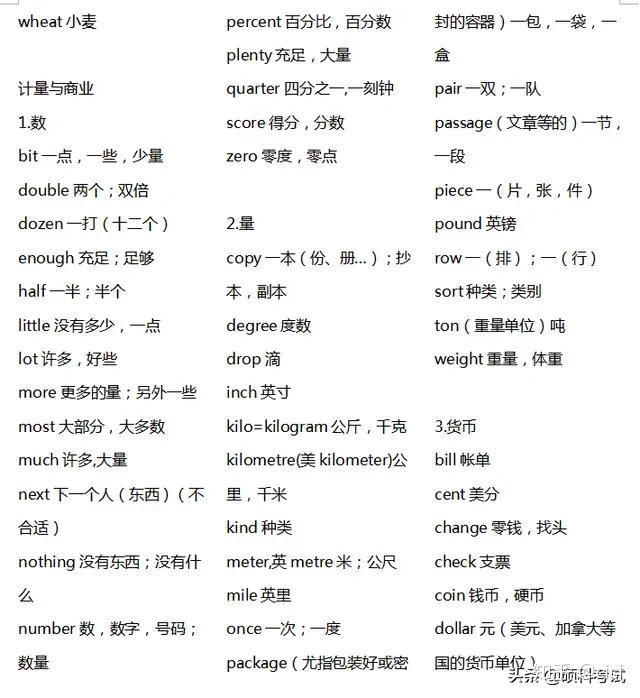

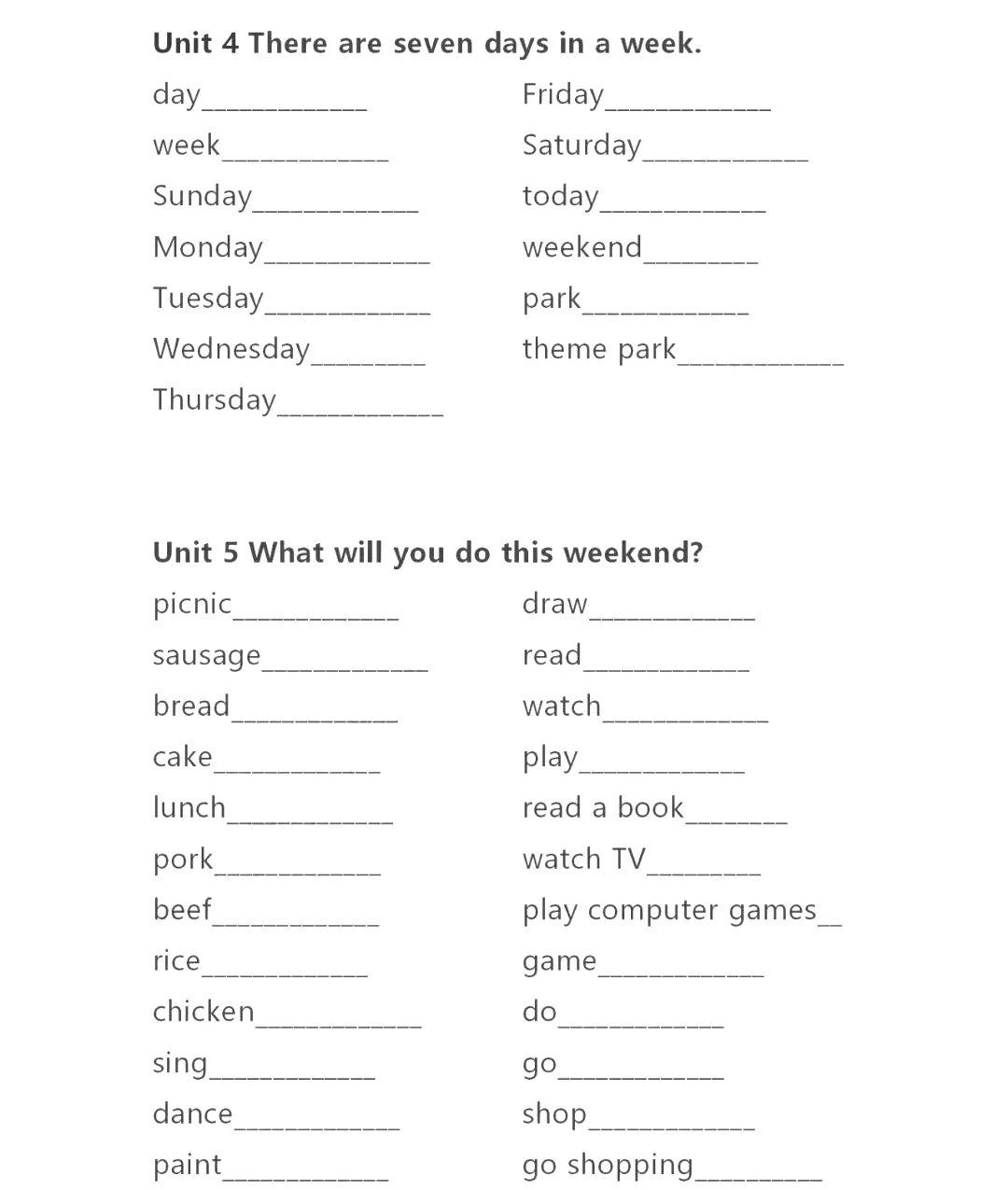

1到100的英语单词 完整版_1到100的英语单词 完整版

*** 次数:1999998 已用完,请联系开发者***

≡(▔﹏▔)≡ 通义千问推出Qwen2.5-Turbo开源AI模型 上下文长度达100万tokens阿里通义千问官方今天宣布,经过数月的优化与改进,正式发布Qwen2.5-Turbo开源AI模型,以满足社区对更长上下文长度的需求。新模型将上下文长度扩展至100万个tokens,等同于大约100万英文单词或150万中文字符,足以包含10部完整的小说、150小时的演讲稿或30000行代码。上下文...

(^人^)

阿里发布Qwen2.5-Turbo,支持100万Tokens上下文为了满足用户和开发者的需求,阿里发布Qwen2.5-Turbo 版本,将上下文从之前的128K扩展至100万tokens,相当于大约100万个英文单词或150万个汉字,足以涵盖10部长篇小说、150小时的演讲稿或3万行代码,使得模型的整体理解、生成能力获得大幅度提升。以理解长篇小说为例,Qwen2...

阿里云百炼上线Qwen2.5-Turbo模型:支持100万超长上下文快科技11月20日消息,阿里云百炼宣布,最新的Qwen2.5-Turbo模型已在平台上线,即日起所有用户可在阿里云百炼调用Qwen2.5-Turbo API,百万tokens仅需0.3元,同时还免费为用户赠送1000万tokens额度。该模型支持100万超长上下文,相当于100万个英文单词或150万个汉字,并且在多个长...

˙△˙ 阿里通义千问发布 Qwen2.5-Turbo 开源 AI 模型Qwen2.5-Turbo 将上下文长度从 12.8 万个扩展至 100 万个 tokens,这一改进相当于约 100 万英语单词或 150 万汉字,可以容纳 10 部完整小说、150 小时的演讲稿或 30000 行代码。IT之家注:上下文长度(Context Length)是指在自然语言处理(NLP)中的大型语言模型(LLM)在一次处理过程中...

Qwen2.5-Turbo上线阿里云百炼平台,模型上下文长度扩展至百万tokens钛媒体App 11月20日消息,Qwen2.5-Turbo上线阿里云百炼平台。据介绍,Qwen2.5-Turbo是通义千问团队回应社区对处理更长序列的需求推出的全新版本模型。该模型该模型支持100万超长上下文,相当于100万个英文单词或150万个汉字。

5年前,那个3岁识3000字,被网友嘲“伤仲永”的小男孩,如今咋样王恒屹不仅能完整地背诵下来,还能动手写,甚至,连英文单词都能准确地读写下来。3岁的王恒屹,在一家人以身作则的耳濡目染下,已经认识了3000多个汉字、背诵100多首古诗,还清楚其内容的意思,甚至能准确地认出200多个国家的国徽。彼时,2017年,短视频风刮了起来。何霞也学着开通...

⊙ω⊙

蜗牛加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:1到100的英语单词 完整版

下一篇:1到100的英语单词完整版打印